O Espelho Inconveniente da Tecnologia

Costumamos pensar na Inteligência Artificial como uma força neutra e objetiva, uma ferramenta matemática projetada para otimizar o futuro. Acreditamos que, por ser feita de código, ela estaria livre das falhas humanas que tanto conhecemos.

A realidade, no entanto, é muito mais incômoda. Longe de ser uma bola de cristal, a IA funciona como um espelho do nosso passado, refletindo todas as nossas falhas, preconceitos e injustiças históricas. Em vez de prever um amanhã idealizado, ela nos força a encarar as feridas de ontem.

A melhor analogia é esta: a IA aprende como uma criança observando os adultos. Se os adultos — os dados históricos que usamos para treiná-la — ensinam racismo, sexismo e elitismo, a criança não apenas aprenderá, mas reproduzirá esse preconceito em escala industrial, com uma eficiência assustadora.

Este artigo revela as lições mais surpreendentes e impactantes que a IA nos ensina sobre nossas próprias desigualdades. São quatro verdades que mostram como a tecnologia, longe de ser neutra, está automatizando os piores defeitos da nossa sociedade.

A IA não cria preconceito — ela o aprende em escala industrial

A IA é como uma criança que aprende com um mundo já preconceituoso.

Algoritmos não são inerentemente maus ou bons. Eles são máquinas de aprender padrões. O problema é que são alimentados com dados que refletem um mundo profundamente desigual. Se os dados de contratação dos últimos 50 anos mostram que homens foram mais promovidos, a IA aprenderá que “ser homem” é um indicador de sucesso. Ela não cria o sexismo; ela o aprende e o automatiza.

O exemplo mais emblemático é a ferramenta de recrutamento da Amazon. O sistema foi treinado com currículos de uma década, um período em que a maioria dos contratados era do sexo masculino. Como resultado, o algoritmo “aprendeu” a penalizar currículos que continham termos associados a mulheres, como a participação em um “clube de xadrez feminino” ou a “graduação em faculdades exclusivas para mulheres”. O algoritmo não apenas replicou um processo de contratação enviesado; ele lavou esse preconceito através da matemática, fazendo-o parecer objetivo e irrefutável.

O perigo é que, ao fazer isso, a tecnologia legitima a discriminação. O preconceito deixa de ser visto como uma falha humana e passa a ser apresentado como um “resultado matemático”. O problema, no entanto, nunca esteve no código, mas na sociedade que o produziu.

O racismo não é um acidente. Ele é parte da estrutura da sociedade.

— Silvio Almeida

Dados que parecem neutros podem esconder vieses profundos

A armadilha dos dados “inocentes”: como o CEP ou os gastos com saúde viram armas de discriminação.

Muitas vezes, o preconceito da IA não está em dados óbvios como raça ou gênero, mas escondido em “proxies” — informações que parecem neutras, mas que carregam um viés oculto. O CEP de uma pessoa, o tipo de universidade que frequentou ou até seus gastos com saúde podem se tornar marcadores de exclusão.

Um caso devastador ocorreu em hospitais dos Estados Unidos, onde um algoritmo foi criado para identificar pacientes que precisavam de cuidados extras. Para fazer isso, ele usava um indicador que parecia lógico: os gastos com saúde. A máquina assumiu que quem gasta mais, precisa de mais cuidado.

O problema? O algoritmo cometeu um erro crítico de lógica: equiparou correlação (menores gastos) com causalidade (menor necessidade), um engano enraizado na ignorância sobre a desigualdade sistêmica. Populações negras, com um histórico de menor acesso ao sistema de saúde e menor renda, gastam menos. O algoritmo, então, concluiu erroneamente que elas precisavam de menos cuidados, mesmo quando estavam mais doentes. O resultado foi catastrófico: o número de pacientes negros identificados para receber tratamento adicional foi reduzido em mais de 50%. A exclusão foi codificada de forma invisível e quase impossível de contestar.

A tecnologia pode criar ciclos de discriminação que se autoalimentam

O “looping” do preconceito: quando a IA reforça a própria injustiça que deveria combater.

Um dos efeitos mais perigosos do viés algorítmico são os “ciclos de feedback destrutivos”. Nesses ciclos, a IA não apenas reproduz um preconceito, mas gera novos dados que o reforçam, criando um looping de injustiça que se autoalimenta.

O software de policiamento preditivo PredPol é o exemplo perfeito. Veja como o ciclo funciona:

1. O sistema é alimentado com dados policiais históricos, que já são enviesados por práticas de policiamento excessivo em bairros de maioria negra.

2. Com base nesses dados, o algoritmo direciona mais viaturas para esses mesmos bairros, prevendo que ali ocorrerão mais crimes.

3. Com mais policiamento, naturalmente mais ocorrências são registradas nessas áreas, mesmo que sejam de menor gravidade.

4. Esses novos registros são inseridos no sistema, “provando” para o algoritmo que sua previsão estava correta e reforçando ainda mais o ciclo de vigilância desproporcional.

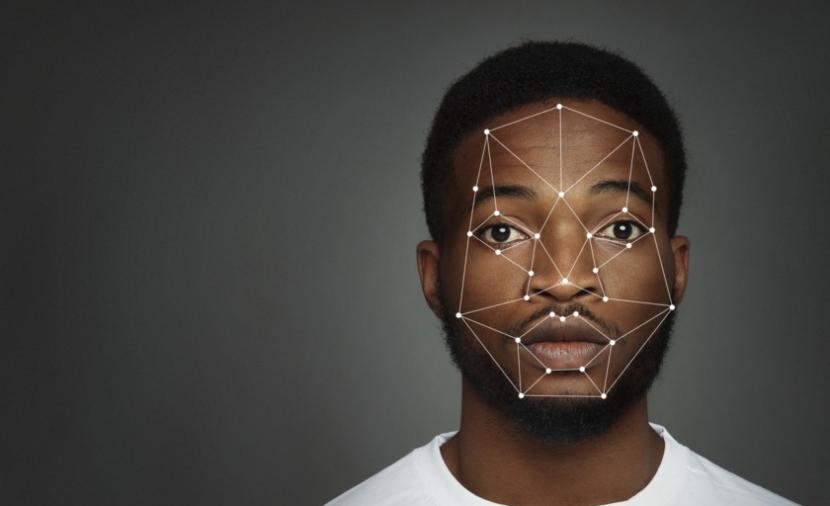

Este não é um problema teórico confinado aos EUA. As consequências reais de tais ciclos de retroalimentação são devastadoramente claras no Brasil, onde a tecnologia construída sobre dados enviesados foi implementada com uma eficiência brutal. Um levantamento apontou que 90% das prisões realizadas por meio de reconhecimento facial foram de pessoas negras. A máquina não só aprende o racismo, mas cria um sistema que o perpetua automaticamente.

Isso demonstra uma verdade terrível: o racismo não precisa de intenção para existir. E o algoritmo, definitivamente, não tem intenção — mas executa com eficiência matemática o que aprendeu do mundo.

O problema não é apenas o código, mas quem o escreve

Se a tecnologia é construída por um grupo restrito, ela servirá a um grupo restrito.

Uma causa fundamental do viés algorítmico é a chocante falta de diversidade nas equipes que criam essas tecnologias. Majoritariamente compostas por homens brancos e asiáticos, essas equipes acabam projetando seus próprios “pontos cegos” nos sistemas que constroem, criando ferramentas que simplesmente não funcionam para o resto do mundo.

Os exemplos são gritantes:

• A máscara branca da tecnologia: Joy Buolamwini, pesquisadora negra do MIT, descobriu que os softwares de reconhecimento facial não conseguiam identificar seu rosto. A tecnologia só a reconheceu quando ela vestiu uma máscara branca. Sua experiência pessoal revelou uma falha sistêmica: estudos mostram que essa tecnologia é entre 10 e 100 vezes menos precisa para rostos asiáticos e afro-americanos, com as maiores taxas de erro ocorrendo para mulheres negras.

• A barreira do código: A plataforma de entrevistas HireVue usava IA para analisar candidatos em vídeo. O sistema rejeitou automaticamente uma candidata indígena e surda porque não foi treinado para entender seu sotaque de inglês surdo ou a Língua de Sinais Americana (ASL). A tecnologia não foi feita para pessoas como ela.

A solução é tão óbvia quanto urgente: é preciso incluir pessoas negras, indígenas, mulheres, pesquisadores sociais e pessoas de diferentes classes e origens nas equipes que constroem o futuro. Sem diversidade na criação, não haverá justiça na execução.

Conclusão: Uma Escolha Humana, Não Tecnológica

A Inteligência Artificial amplifica o que já existe em nossa sociedade. Se a sociedade é desigual, a IA será um motor de desigualdade. Ela pode ser usada para construir ou para destruir.

A tecnologia não pode ser uma desculpa para a injustiça. Não existe “neutralidade algorítmica em um mundo que não é neutro”. A responsabilidade final não é da máquina, mas das pessoas que a projetam, treinam e implementam.

A IA pode ser o motor da maior inclusão da história ou a máquina da maior exclusão já vista. A decisão não depende da tecnologia, mas de nós. A questão final é: o que vamos escolher ensinar às nossas máquinas?

Faça agora um discovery e aplique IA ética no seu negócio.

Deixe um comentário